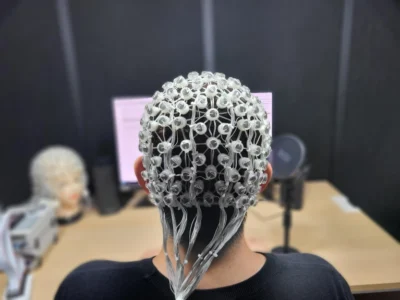

(Intelligenza artificiale-Immagine: elettrodi di elettroencefalografia (EEG) situati sul cuoio capelluto per catturare i segnali cerebrali).

Un’intelligenza artificiale in grado di tradurre i segnali cerebrali in parole e azioni potrebbe un giorno trasformare la vita delle persone con disabilità.

Sebbene smartphone e social media stiano diventando sempre più parte integrante delle nostre vite, la comunicazione verbale rimane il modo più comune di interazione delle persone. Tuttavia, alcune persone nascono senza, o possono perdere improvvisamente, questa capacità di comunicare a causa di disabilità fisica o malattia.

Ora i progressi nelle tecnologie che convertono l’attività cerebrale in voce o testo stanno aprendo la strada alla comunicazione tramite segnali cerebrali che potrebbero fornire un mezzo di comunicazione senza voce e migliorare enormemente la vita delle persone con disabilità.

Dagli anni ’90 neurologi e informatici hanno utilizzato l’IA per colmare il divario tra i pensieri di una persona e le azioni che desidera intraprendere. Le interfacce cervello-computer (BCI) utilizzano segnali elettrici generati quando una persona immagina qualcosa, come muovere il braccio, per controllare un dispositivo esterno, come un arto robotico.

I segnali cerebrali possono essere misurati in modo non invasivo utilizzando l’elettroencefalografia (EEG), un metodo che utilizza elettrodi posizionati sul cuoio capelluto.

Curiosità sul cervello

“Da giovane studente ero sempre curioso di sapere come funziona il cervello”, afferma Seo-Hyun Lee, un ingegnere neurale del Dipartimento di ingegneria cerebrale e cognitiva della Korea University a Seoul, in Corea del Sud. “Ma come dottorando, voglio fare di più che svelare i suoi misteri. Identificando l’attività cerebrale innescata dal pensiero di determinate parole, spero che possiamo creare una tecnologia che aiuterà le persone che non possono parlare o che hanno perso la capacità di parlare”.

La conversione dei segnali cerebrali in linguaggio naturale è impegnativa poiché i dati EEG sono estremamente rumorosi, quindi lo sviluppo di un’IA avanzata in grado di individuare le caratteristiche chiave dei dati è molto importante.

C’è stato un certo successo nella generazione del parlato da segnali catturati da elettrodi impiantati chirurgicamente o mentre i pazienti parlavano ad alta voce. Tuttavia, per consentire la “conversazione silenziosa” per applicazioni più ampie nella nostra vita, come la generazione di testo su un computer senza digitare su una tastiera, saranno fondamentali tecniche molto più semplici e meno invasive. “Ora siamo estremamente interessati a generare voci senza la necessità di impiantare elettrodi nel cervello e solo da un linguaggio immaginario”, afferma Seong-Whan Lee, Professore di intelligenza artificiale e ingegneria cerebrale presso la Korea University.

Il “discorso immaginato” è quando qualcuno immagina di parlare senza emettere un suono (“discorso parlato”) o mimare le parole (“discorso mimato”).

Il laboratorio di Lee, supportato da una sovvenzione dell’Institute of Information & Communications Technology Planning & Evaluation (IITP)*, è specializzato nel riconoscimento di schemi e nell’apprendimento automatico, con particolare attenzione ai modelli di segnali cerebrali legati al parlato. “L’obiettivo principale della nostra ricerca è utilizzare questi modelli per analizzare ciò che una persona sta pensando e prevedere ciò che vuole dire”, afferma Lee. “L’attuale tecnologia BCI è in gran parte basata su testo e audio, ma in futuro speriamo di utilizzare i segnali cerebrali dal parlato immaginario, poiché possono essere molto diretti e intuitivi”.

Un approccio ponderato

La tecnologia brain-to-speech combina diverse aree chiave dell’IA, tra cui: BCI; strumenti di apprendimento profondo che catturano caratteristiche significative da segnali cerebrali complessi e tecnologia di sintesi vocale. In un tale sistema, una persona immagina di dire “Come stai?”, l’EEG registra i segnali creati da questo pensiero, il modello di apprendimento profondo decodifica le caratteristiche del messaggio dai segnali cerebrali e, infine, sintetizza la voce dell’utente utilizzando il caratteristiche.

Seong-Whan Lee, Seo-Hyun Lee e il team della Korea University hanno sviluppato una tecnologia cervello-voce in grado di riconoscere e generare 12 parole da segnali vocali immaginati registrati con una misura non invasiva, l’EEG. Questo rappresenta un passo significativo verso le applicazioni cervello-voce, dal momento che studi precedenti hanno comportato solo la classificazione di diverse parole e il team ha dovuto superare sfide significative.

Uno scienziato della Korea University che monitora l’esperimento EEG.

“La registrazione dei segnali elettrici attraverso il cuoio capelluto rende più difficile individuare i segnali vocali poiché i capelli e la pelle introducono molti artefatti, quindi abbiamo dovuto sviluppare un metodo per rimuoverli”, afferma Seo-Hyun Lee. “Tra i lati positivi, il discorso immaginato genera meno artefatti rispetto al discorso mimato e parlato, perché non c’è alcun movimento coinvolto”, aggiunge.

Un altro problema è che, a differenza del parlato, il parlato immaginato non ha registrazioni vocali che l’IA possa controllare, né l’audio necessario per addestrare il sintetizzatore vocale. “Dobbiamo identificare l’esatto inizio del discorso immaginario nei segnali cerebrali e abbinare questi segnali alla voce dell’utente corrispondente”, afferma Seo-Hyun Lee.

Per scoprire questi segnali unici, il team di Seong-Whan Lee ha raccolto un ampio database di segnali vocali immaginati e parlati utilizzando 12 parole comunemente utilizzate nella comunicazione con i pazienti, come “aiutami” e “grazie”. I partecipanti hanno eseguito tre sessioni, dicendo ripetutamente una parola ad alta voce, immaginando ripetutamente di dirla e ripetutamente immaginando di vederla. Il team ha quindi utilizzato un modello di intelligenza artificiale per cercare schemi nei segnali EEG registrati e imparare a quali parole e suoni associarli.

Vedi anche:Il progresso nel campo dell’intelligenza artificiale sarà la chiave per la longevità

“Abbiamo osservato caratteristiche comuni tra i due tipi di discorso, come tempi, posizione e intensità dei segnali elettrici, nonché schemi spaziali simili, con entrambi i tipi di discorso che illuminano aree simili del lobo temporale sinistro e della corteccia frontale”, dice Seo-Hyun Lee.

“Abbiamo ulteriormente studiato le caratteristiche intrinseche del discorso immaginario confrontando i risultati dell’EEG con i segnali di immagini visive, per cui i partecipanti immaginano semplicemente un’immagine della parola, come un orologio”, aggiunge. “È interessante notare che hanno anche mostrato una correlazione significativa tra loro, con gruppi di parole che creano segnali simili”.

Utilizzando le caratteristiche ottimali, il loro modello è stato in grado di distinguere sottili differenze tra i segnali e ha imparato con successo a riconoscere le 12 parole dal solo discorso immaginario. Inoltre, il loro modello di intelligenza artificiale potrebbe tradurre con successo un EEG di un discorso immaginario in un discorso sintetizzato con la voce dell’utente a livello di parola.

Tecnologia cervello-voce

Il team sta lavorando a un prototipo virtuale per evidenziare il potenziale della combinazione dell’IA con la tecnologia dell’informazione e della comunicazione, i big data e la robotica nelle case intelligenti, in modo che le persone con disabilità possano controllare il riscaldamento, l’illuminazione, l’intrattenimento e gli elettrodomestici semplicemente pensando .

“Siamo ancora lontani dalla sintesi di frasi complete dal suono naturale oltre il livello delle parole dal discorso immaginario, ma troviamo sempre potenziali modi per migliorare la nostra tecnica”, afferma Seo-Hyun Lee. Spera che possano raggiungere questo obiettivo nel prossimo decennio in modo che possano iniziare ad avere un impatto positivo sulla vita dei pazienti.

“Le persone con disabilità o malattie come la sclerosi laterale amiotrofica (SLA) possono eventualmente perdere la capacità di parlare”, afferma Seo-Hyun Lee. “La tecnologia brain-to-speech può essere utilizzata per registrarli mentre parlano mentre sono ancora in grado, in modo che un giorno possano parlare di nuovo con la propria voce”.

Fonte:Nature